文|IT时报记者 郝俊慧

编辑|孙妍

北京时间6月3日晚9点30分,美股开盘,经过一个“漫长”的周末,全球都在等待一个答案:英伟达能否超过苹果,成为全球市值第二的公司。

截至北京时间4日凌晨4点收盘,奇迹并没发生,但两者差距进一步缩小。英伟达当日上涨4.9%,市值为2.83万亿美元,一夜大涨1270亿美元,折合人民币约9000亿元。苹果则定格在194.03美元,市值为2.98万亿美元。

此前一天,英伟达创始人兼首席执行官黄仁勋在2024中国台北国际电脑展上发表主题演讲,并宣布最新产品Blackwell已经量产,并预计将于2025年推出增强版Blackwell Ultra GPU。

这不是全部。

“英伟达将每年更新一代产品。”会上,黄仁勋首次对外公布了预计2026年上市的下一代CPU“Vera”以及GPU“Rubin”,命名灵感来源于宇宙暗物质研究先驱、美国女天文学家Vera Rubin,这个速度打破了以18个月为周期的“摩尔定律”。当日,特斯拉CEO埃隆·马斯克表示,旗下人工智能初创公司xAI将购买30万块英伟达B200 AI芯片。

长达近2个小时的演讲中,“皮衣教主”展示了一个强大的英伟达NVIDIA 生态:芯片、系统、容器、网络、平台……基于GPU和CUDA,英伟达构建了强大的护城河——“AI工厂”。

72颗“芯”组成的超级GPU

距离GTC发布还不到3个月,Blackwell便已经量产。

黄仁勋手里拿着的GB200,被称为“史上最强”GPU,由两块Blackwell GPU和一块Grace CPU组成,两块芯片以每秒10TB的速度链接,采用台积电4纳米制程工艺,共有2080亿个晶体管,其AI性能为每秒20千万亿次浮点运算。

2016年,英伟达推出新一代GPU架构Pascal,单芯片算力为19Tflops(每秒19万亿次浮点计算),并以此为基础推出了第一代AI超级计算机DGX1,算力为170Tflops(每秒170万亿次浮点计算),黄仁勋将这台机器交付给一家旧金山的初创公司OpenAI。

如今,八年过去,英伟达GPU芯片的计算能力、浮点运算以及人工智能浮点运算能力增长了1000倍,“这速度几乎超越了摩尔定律在最佳时期的增长。”黄仁勋说道。

基于Blackwell的英伟达新一代系统DGX B200也被黄仁勋带到了电脑展,这块硕大主板上配备8块GPU,每个DGX 系统提供144PFlops(每秒144千万亿次)的FP4浮点运算性能,1.4TB海量显存和64TB/s显存带宽。黄仁勋透露,DGX B200采用传统的风冷结构,支持x86系统,配备于已发货的服务器中。

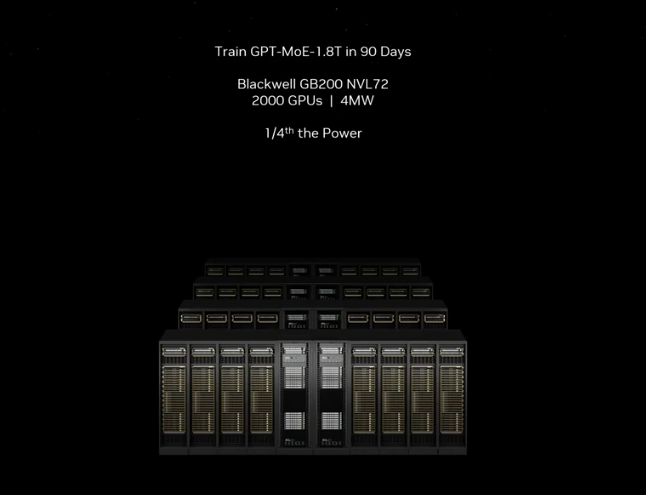

但这依然不是One more thing。基于DGX系统,英伟达设计了全新的液冷系统MGX,每个节点集成四块GB 200超级芯片(8块Blackwell),九个节点,总共72块Blackwell通过NV-Link形成了一个“超级GPU”,背后的NV Link主干由5000条铜线组成,加起来长达3公里,其中的收发器可以驱动信号跑完整个线路。

Hopper时代(H100、H200时期)的DGX系统最多只能同时支持8块GPU,而MGX使NVlink可驱动的GPU数量增加了8倍,带宽增加了17倍。从功率上看,Blackwell的功耗略高于Hopper,9倍的GPU数量整体耗能是原先的10倍,但AI FLOPS(每秒浮点运算次数)提升了44倍,达1440PFlops,算力的“通货膨胀率”相当于1:4.5。

越来越像“半导体界的苹果”

“Buy more and save more(买得越多省得越多)”,黄仁勋一向擅长向CEO们兜售他的“CEO数学”。

不过,即便是对于财大气粗的全球顶尖互联网公司而言,Blackwell的价格也很“辣手”。

英伟达还未公布Blacwell的价格,但有汇丰银行分析师认为,英伟达“入门级”B100 GPU 的平均销售价格(ASP)将在 3 万至 3.5 万美元之间,与英伟达 H100 的价格相差无几,而功能更强大的GB 200,价格可能在6万至7万美元之间。至于搭载Blackwell GPU的MGX服务器,单价预计高达 300 万美元(约等于2174万人民币)。

“Blackwell正在满负荷生产。”5月22日举行的英伟达一季度财报业绩说明会上,黄仁勋透露,Blackwell将在第二季度开始交付,三季度产能爬坡,四季度便能让客户建成基于Blackwell的数据中心。

在黄仁勋的设想中,英伟达交付的是一座AI工厂,构建了覆盖整个数据中心的解决方案,一个综合CPU、GPU、NVLink、NICK(特定技术组件)以及NVLink交换机等多个元素的完整系统,甚至可以说是为人工智能巨头提供的“交钥匙方案”,“为此,我们不遗余力地将所有技术推向极限,无论是台积电的工艺技术、封装技术、内存技术,还是光学技术。”黄仁勋表示。

这听起来就是个“极致”昂贵的方案,可至少在目前,英伟达还没有竞争对手。尽管最近各大巨头都有自己的芯片规划,谷歌、英特尔和高通成立了UXL基金会,专门用来开发一套支持多种AI加速器芯片的软件和工具,以此对抗英伟达的CUDA生态。但黄仁勋明确的“一年一更新节奏”,使这种追赶还未出“起跑线”,便有被“超圈”的感觉。

在介绍产品细节时,黄仁勋明确指出,所有产品保持100%的架构兼容性,也就是说,Hopper可以平滑升级至Blackwell,而且所有软件都具有向后兼容的惯性。也正因此,Blackwell平台从问世到投产的时间,明显快于此前的A系列和H系列。

黄仁勋一口气宣布了三年升级计划:2025年是Blackwell Ultra,2026年是新一代的Rubin,2027年是Rubin Ultra。

至少在两年内,“尺度定律”(scaling law)在通用大模型迭代上仍有决定性作用,对英伟达而言,这是比算力增长“黄氏定律”还要深的护城河。

参数级越大的大模型训练,越依赖于超大规模的GPU集群以及超高速的GPU连接。英伟达的新一代NVLINK交换机拥有500亿个晶体管,74个端口,每个端口的数据速率高达400 GB,是72颗芯片变成1颗超级芯片的“幕后功臣”。

如果说NVLINK解决的是GPU和GPU之间的连接问题,那么将一个个AI服务器连接起来的网络交换机也是必须的。以往,英伟达专注于InfiniBand交换机,一种高效但需要专用技术的设备,有一定应用门槛,但现在英伟达推出了面向以太网的交换机——Spectrum X800,可以每秒51.2 TB的速度和256路径(radix)的支持能力,为成千上万的GPU提供了高效的网络连接。Spectrum同样是一年一升级,预计两年后发布的X 1600,是为更大规模的数据中心设计,能够满足数百万个GPU的通信需求。

英伟达今年一季度财报显示,与去年相比,不仅计算收入增长了5倍多,网络收入也增长了3倍多。

英伟达还推出了一种推理微服务NIM,可以通过优化的容器形式提供模型——部署在云、数据中心或工作站上,开发者不再需要使用具有不同功能的多个模型来生成文本、图像、视频、语音等,只要使用NIM,便可以轻松地为copilots、聊天机器人等构建生成式 AI 应用,所需时间从数周缩短至几分钟。

无论是对软硬件生态极致的追求,还是一年一升级的节奏,英伟达越来越像半导体界的苹果。

AI的尽头是电力

不过,再理想的未来,在能源问题面前,也可能会放缓脚步。

IEA 最近的《电力 2024》报告预测,到 2026 年,人工智能数据中心的电力需求将达到 90 太瓦时(TWh),这意味着,数据中心的关键IT电力容量要达到约10吉瓦(GW)功率,相当于730万个H100的电力需求。

打造百万块GPU芯片超级集群的数据中心,并非不可能。黄仁勋在演讲中放言,“随着技术的不断进步,数百万个GPU的数据中心时代指日可待。”

“宏伟”目标背后暗含的判断是,一方面,更大、更复杂的大模型需要被训练,另一方面,未来的互联网和计算机交互将越来越多地依赖于云端的生成式人工智能,而所谓云端背后,依然是超大规模的智算中心。

但电在哪里呢?不久前,AWS(亚马逊云科技)刚刚以6.5亿美元购买了一个 1000兆瓦的核能源数据中心园区,可分析机构SemiAnalysis认为,亚马逊还有很多年才能实现整个电力供应能力。

SemiAnalysis曾测算,在利用率为80%且PUE为1.25的情况下,一个有20480个GPU集群的数据中心平均将从电网获取 28~29MW 功率,每年总计能耗25万兆瓦时左右。因此,数据中心、云服务商、大模型厂商必须考虑在现有电力供应条件下进行训练。

来自供应链的估算,英伟达在2024年将出货300 万个以上GPU,对应超过 4200兆瓦时的数据中心需求,接近当前全球数据中心容量的10%,而这只是一年的 GPU 出货量。

不难理解,为什么最近几次演讲中,黄仁勋反复强调英伟达GPU日趋下降的算力能耗比。

以Pascal为例,训练GPT-4模型将消耗高达1000吉瓦时(1吉瓦时等于1000兆瓦)电能,放眼全球,暂时还没有一个数据中心具有这么高的电力配备,这也是2020年前大模型为什么没有出现的原因之一。

从时间上看,训练一次GPT-4,使用Pascal大概需要一年;使用Hopper,可能需要三个月;换成Blackwell,10000颗芯片训练同样大小的模型,只需要3吉瓦时,耗时10天。

这是GPT-4模型首次公开训练数据:2万亿参数和8万亿Token。参数量是GPT-3.5的11倍之多。

只是问题在于,业内普遍认为,GPT-4o,甚至GPT-5的参数级应该在数十万亿以上。因此,尽管黄仁勋表示,Blackwell使得生成每个Token只需消耗0.4焦耳的能量,可从绝对值上看,每台DGX H100服务器的平均功率在11千瓦左右,每台DGX B200耗能15千瓦,而MGX的功率是100千瓦。

事实上,大多数现有的数据中心尚未准备好支持每机架 20kW 以上的功率密度。一位数据中心人士曾告诉记者,原先能放10U的传统服务器机架,现在只能放一台智算服务器。

大批新型智算数据中心正在投建。SemiAnalysis的一份报告确认,OpenAI 计划在其最大的多站点训练集群中部署数十万颗GPU,这需要数百兆瓦的关键IT电力供应。同时,有消息传出,Meta的H100安装量会达65万颗。

“真正的电力短缺局面即将到来。”SemiAnalysis在报告中指出,全球数据中心关键IT电力需求将激增至2026年的96吉瓦,其中人工智能将消耗约40吉瓦。

AI的尽头是电力,而英伟达的最终对手,可能也是它。

排版/ 季嘉颖

评论