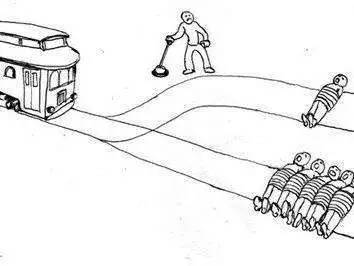

自动驾驶会遭遇“电车难题”吗?

1967年,菲利帕·福特发表的《堕胎问题和教条双重影响》中,首次提到了“电车难题”。之后“电车难题(Trolley Problem)”是伦理学领域最为知名的思想实验之一。而近日,有国外学者发表了有关"电车难题"的伦理调查结果,而发起研究的原因则与自动驾驶汽车有关。

救一人人还是救五个人的电车难题

有史以来最大的机器伦理调查

出于对自动驾驶汽车引发道德难题的好奇,麻省理工学院的学者Iyad Rahwan发起一个名为Moral Machine(道德的机器)的研究。

目前该研究报告于10月24日发布在著名杂志nature的官网上。学者Rahwan牵头集结了一个包括心理学家,人类学家以及经济学家的国际化团队去创建Moral Machine这项研究。

麻省理工学院的学者Iyad Rahwan,Moral Machine研究的发起人

这项调查列出了13个设想情景,而这些设想情景里面某些人的死亡是无可避免的。调查对象被要求在涉及各种变量的情况下选择拯救谁:依法驾驶的司机还是不按交通规则的行人,年轻的还是年纪大的,穷人还是富人,多数人还是少数人。该调查在18个月内,线上测试已经记录了来自233个国家和地区的人做出的4千万个决定。这也是有史以来最大的机器伦理调查。

而最后研究根据结果认为,指导人们做出道德决策的原则是因地而异,那么为自动驾驶汽车建立一套普适性的道德原则是件不太可能的事情。

这一结论的前部分是老话题了。“道德”本来就是一个至今仍然未能得出相一致结论的概念,毕竟“你之蜜饯我之砒霜”。但是值得深思的是,未来自动驾驶汽车做出决策的原则是用一个所谓的普世原则还是照顾当地而因地制宜呢?

难以统一的道德?

收集到的数据显示,无论参与者的年龄、性别以及国籍,大多数人都将人类利益置于宠物之上,集体利益置于个人利益之上。这个小结论并不出人意外,毕竟事关生死,大多数人本质上还是认同人类本位以及集体本位。而上述数据的结论也符合世界上第一份自动驾驶指导原则。

早在2017年,德国联邦交通部的伦理委员会率先提了世界上第一份自动驾驶指导原则。其核心要点是:

当系统引发的事故少于人类司机时,伦理上需要应用自动与互联驾驶。

财物损失优于人身损失:在危险情况下,保护人类生命始终拥有最高优先权。

发生不可避免的事故时,不可根据行车者的个人特征(年龄、性别、身体或精神状况)做出鉴定。

所有的驾驶情况必须有清楚的规定,并能明确驾驶责任方是人或电脑。对此必须有记录并存储下来。

司机必须能够自己决定驾驶数据的转交和使用(数字主权)。

不过意见趋近的仅限以上。研究人员在剔除掉样本不足100个的国家之后,分析了剩下的至少有100名受访者的130个国家的人的回答。根据回答的差异性,最后发现这些国家可以被分成三组。第一组是以基督教占主导地位的北美以及几个欧洲国家;第二组则包括儒家思想辐射区以及穆斯林传统的国家,例如日本、印度尼西亚以及巴基斯坦;第三组则由中美洲和南美洲构成。第一组希望牺牲老人拯救年轻人的倾向比第二组更强烈。两者的差异可能与儒家思想和穆斯林的尊老敬老爱老传统有关。.

数据还表明了一个国家的社会和经济因素是与居民的主流意见存在相关性的。该团队发现,那些国家行政制度强大的人——例如芬兰人和日本人——比国家制度弱的人——例如尼日利亚和巴基斯坦——更倾向于选择撞倒那些不按照规则行事的人。

而在选择拯救路边一个流浪汉还是另一边的高级行政人员的设想情景中则揭示了另一个点:人们做出的选择是与他们国家收入不平等的水平有关联的。芬兰人没有任何一方的明显偏向。(2016年,在经合组织(OECD)贫富差距最小国家中芬兰排名第五)但哥伦比亚的主流回应是选择牺牲社会地位低的人。(哥伦比亚在联合国发展计划署观测的134个对象国家中,贫富分化程度高居第14位)

自动驾驶汽车会遭遇“电车难题”吗?

该调查发布的时间已经过去了几天,目前已有自动驾驶汽车规划与测试的科技巨头们仍然未发表任何意见。虽说如此,该调查也是存在争议的。南卡罗来纳大学哥伦比亚分校的法学教授Bryant Walker Smith怀疑Moral Machine的研究是否真的具有实际作用。因为现实当中很少有面临着如此极端的冲突而且能够做出选择的例子。研究的一方则为自己辩护,他们设想的情景代表了人类司机日常所要面临的道德决策。如果政府与自动驾驶汽车的制造商想要得到大众接受的话,那么他们必须把这些东西考虑进去。

反方认为设想情景过于极端和绝对,缺乏现实参考性;正方则坚持认为设想具有代表性,而且也认为该研究可以促进自动驾驶伦理规范议题的讨论。

而在实践中,人与机器终究是不同。人的价值观实际上也不是恒定的,决策也一样。设想是一回事,实际操作又是另一回事。人的决策是存在暧昧与弹性的。但是机器不同,机器的决策逻辑是刚性的,一旦决定了什么样的道德逻辑,那么执行的命令是绝对。而人类对这种执行的刚性会感到不安。

快手CEO宿话说过,“社区运行用到的算法是有价值观的,因为算法的背后是人,算法的价值观就是人的价值观,算法的缺陷是价值观上的缺陷。”所以,看似是自动驾驶汽车会遭遇"电车难题",实际上还是人类来面对这个变态选择,毕竟向自动驾驶汽车注入执行逻辑的终究是人本身。

评论