文 | 真故研究室 林秋艺

编辑 | 龚正

ChatGPT已经在科技圈火热一月有余,但仍有很多大众关心,ChatGPT于个人的职业、学业有何价值、自己该如何与ChatGPT时代相处。

也有很多人脑洞大开提问,ChatGPT能帮自己做副业吗?能成为自己的良师益友、解决自己的精神内耗吗?另外也有瞧不上ChatGPT的声音。前一阵,ChatGPT连小学数学题都算不对的新闻也传播了一番。一些家长形成了先行印象,认为这哪里算得上AI。

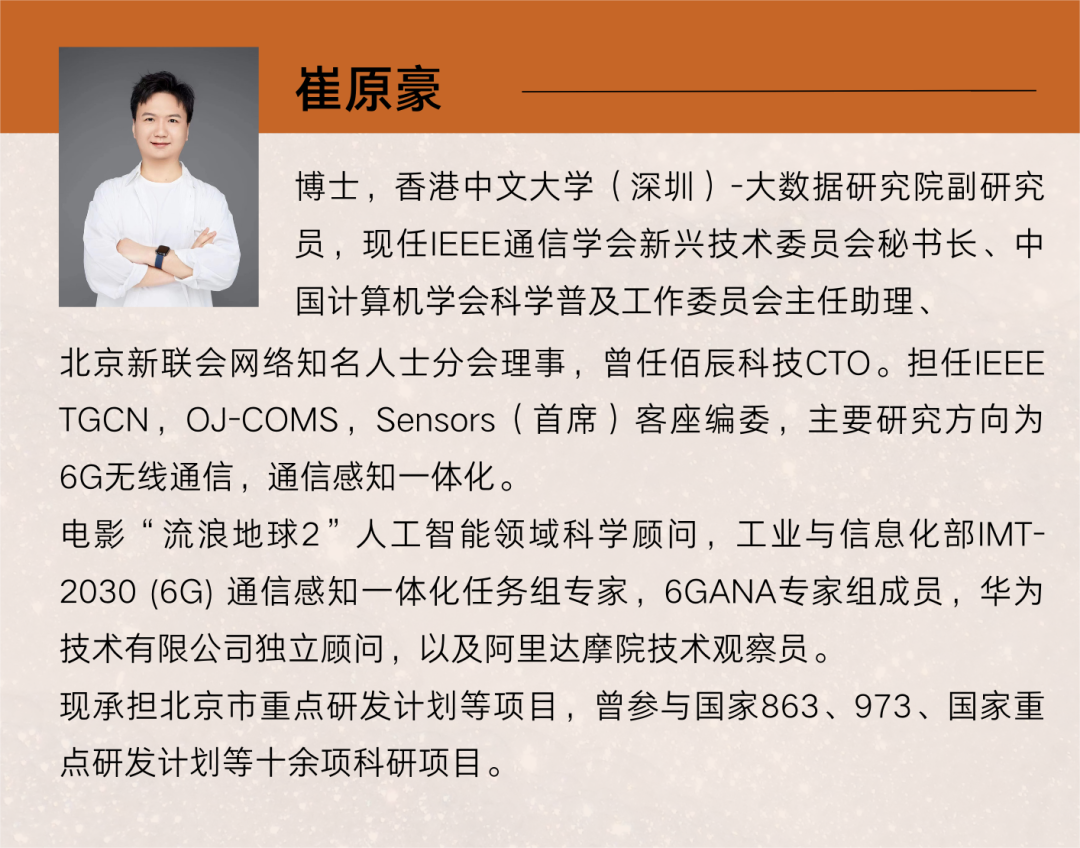

对此,我们对话了中国计算机学会科学普及工作委员会主任助理、香港中文大学(深圳)大数据研究院副研究员崔原豪博士。他也是电影《流浪地球2》中人工智能领域科学顾问。请他分享了ChatGPT的诸多硬核洞察。

崔原豪的核心观点如下:

1、AI替代的不是人类,而是不会使用AI的人类。关注ChatGPT的原因在于,我们应该了解将来如何使用ChatGPT相关的AI产品去提升自己的工作效率,这是未来工作中的最优选择。当世界在进步时,一成不变就将形成数字鸿沟,从而影响自身发展。

2、机器在计算能力上会高于人类,但机器智能始终无法如人类智能一样思考。迄今为止,还没有发现AI有超越人类智能或者企图反叛人类的苗头。评价机器是否智能只有通过图灵测试,但真正完备的图灵测试无法实现。

3、ChatGPT目前还无法分辨信息的真实性。下一步,需要在数据层面集中增加更多关于世界常识的标注数据;在它原有的记忆上更新,因为随着时间的进程,某些事实和知识都会发生变化,它需要不断更新。

以下为对话实录:

Q1:您第一次接触ChatGPT是什么时候?使用体验如何?

A1:大概是在2个月前,第一次使用了ChatGPT。当时用它做了一篇英文论文的润色,让ChatGPT帮我推敲其中的语法,结果超乎我想象的好。

我告诉它:你现在是一个英语翻译家,我希望你把我说的话翻译成优雅且简练的英语句子,不要作过多解释,也不要改变它的原意。

这里每一个“要”或“不要”都是一个指示。在这几条指示的要求下,它就会把你输入的一段英语文本变得更加优美简洁。

这比以前用的Grammarly(英语语法检测)润色出来的效果好很多。专业性上,ChatGPT会做很多专业术语的替换,这是之前的语法检测工具很少能做到的;文法方面,被它替换后的词汇和语法相较之前会更优雅一些。

Q2:现在对ChatGPT的复用率如何?

A2:最近更多的是用它来做论文润色、英语翻译或其他语言翻译,有时候也会逗它玩一会儿。

它的使用过程还是挺有趣的,像是工作助手,大幅度地减少了我的工作时间,提高了效率。

Q3:请教一个根源性的问题,在人工智能中,大语言模型扮演着怎样的角色?

A3:要了解大模型的角色,我们首先要了解机器如何评价一段文本的好坏。

举个例子,《流浪地球2》里有一句经典台词“我相信人类的勇气,可以跨越时间,跨越每一个历史、当下和未来。”

假如我把句子顺序调整一下,“我相信勇气的人类,可以跨越时间、当下、未来,跨越每一个历史。”大家会觉得有一点奇怪,但还是能听出来我说的是什么意思。

但当我把它整体打乱,变成“人类勇气未来,时间当下跨越每一个,可以我相信的历史”,你就会觉得无法理解。

我们会觉得第一个句子非常合理,最后一个不合理的原因是,在我们人类所有的语言里,最后一个句子出现的概率非常低。

从统计角度来看,在“人类语言模型”里,第一句话发生的概率最大,第二句话次之,第三句话几乎不可能发生。这就是文本合理性的量化。

机器就是在它的训练集中,获得文本合理性的量化指标。如果训练集足够泛化到含括所有的语言模型,那么机器就有资格评价这段文本是不是符合人类语法。

当你让它生成一段新的文本时,它会按照人类最常用、最喜欢的方式生成,从语法结构上来看,你会觉得它说得很有道理,但事实层面却不一定对。

也就是说,语言模型本身就是自然语言处理的一个领域基石。

语言模型的好坏,决定了整个下游任务处理的好坏,因为是它在评价语言是不是合理。如果刚开始评价指标就错了,那么后边的所有东西都会变成错的。所以语言模型是根本。

Q4:有声音认为,ChatGPT是一个颠覆式的创新,它的颠覆性体现在哪?

A4:我个人觉得颠覆性其实体现在,它变成了一个可以直接面对用户的产品。

以前大家做大模型的目的,第一是可以完成更多的自然语言处理任务,第二个是可以在每个细分的载源处理任务上可以去刷新,去达到更高的进度。包括谷歌的大模型、微软的大模型,还有智源研究院的大模型。

但是很少有人去站在用户的角度去想:我们是不是可以去做一个大家都可以用得起来的人工智能产品。

以前所有的人工智能产品,比如小冰、小爱同学,或者是手机里边的图像处理、图像增强的算法也都是内嵌在其他产品里边的,并没有真正打包成一个完全的人工智能的产品去卖给用户。

现在ChatGPT就是每个人都可以用得起来一个产品,大家都可以接受他能做到什么程度,而且它还可以接入更多人工智能的算法,包括图像和视频领域的算法。

Q5:许多用户实测之后发现,ChatGPT在与人沟通上虽然已经相当地智能化,但有时“也会一本正经的胡说八道”,从技术角度上看,造成这一结果的原因是什么?

A5:主要原因是ChatGPT还不懂什么是“事实”。

ChatGPT的训练过程第一步是预训练。预训练是采用无监督训练的方法,也就是把网络上的数据包括其他的东西,交给它来进行自我训练。

这造成的一个结果就是,它不知道这些东西哪一个是真的,哪一个是错误的。

因为预训练模型是一个语言模型,它的主要目的是去了解人类的语言习惯,包括单词之间的构造关系,只要学足够多的文字语料,这些语义信息都是可以被抽取出来的。

但是抽取出来的关于世界的常识,它自己是无法评判真实性的,需要人类来进行标注。

下一步,如果它要变得更能分辨事实的话,就需要再加入很多关于世界常识的标注数据,人类需要对哪一些是真的世界常识去做标注。

另外一个,它需要做一个记忆上更新,因为有很多事实是冲突的,随着时间的进程,某些事实和知识会发生变化,它需要不断更新。

Q6:ChatGPT接下来应该在哪些方面做改进,来变得更为智能?

A6:这个还是要从智能本身的定义来想,什么叫“智能”?

我一直觉得在这个领域里边没有一个普适的评价基准,去评价机器或者大语言模型本身的能力。现在是根据每一个细分任务去评价它的准确度,但是准确度其实跟智能没有太大关系。

要评价它是否智能就需要通过图灵测试,但是真正完备的图灵测试是实现不了的,因为它要求的是人与机器不断交互,这是一个无限长的过程,基本上无法实现。

如果是限定时间内,人和机器的交互,其实是有可能会被机器骗过去的。

比如,你和一个大语言模型聊5分钟,如果话题比较窄,可能你就会觉得它已经达到人类的标准了。

但是如果你跟它聊得非常宽泛,把范围扩展到它未曾接触过的领域,或者你跟它聊大概一个月左右,你可能就会觉得它确实不是一个人。

所以,如果是从标准的测试层面来说,现有的大语言模型应该都无法通过测试。

Q7:像人脑一样去思考和创造,是否是科学界对ChatGPT定性的终极目标?

A7:大方向上是朝着“人脑”这个方向努力的,但是在真正的研究过程中其实反而没想这么多。

比如,在ChatGPT的研究过程中,最开始的时候机器是需要人的提示的,你需要给它一个例子,它会按照这个例子把你想要的内容生成出来,但是现在已经演变到你直接给它下命令,它就能生成的程度。

所以,实际上它确实是在朝着一个既定的目标去研究的,但是这个既定目标可能并不一定是为了更智能,也可能是为了让它变得更容易使用。

Q8:人类随年龄越长越充满智慧,ChatGPT也会随着年限增长,变得更聪明吗?

A8:我觉得这个不一定,因为知识是需要更新的。

人类大脑有一个遗忘的功能,这非常重要,因为大脑的储存容量是有限的,现在我们每天都会接收到很多的信息,从视觉、听觉、嗅觉,包括皮肤都可以接受到非常细微的刺激。

人类的大脑有注意力机制和遗忘机制,我们会注意到我们感兴趣的信息,也会遗忘掉很多细节信息。这两个机制保证了人类大脑不会被过多的信息冲垮。

对于大语言模型来说,现在注意力机制已经有了,但遗忘机制还没有。

现在的大语言模型还只是一个“新生”的阶段,它的训练并不是像我们人类在现实生活中实时训练,而是在训练之后使用一段时间,然后再更新、再训练。

在使用过程中训练是我们人类独有的能力,而大语言模型无法在使用过程中训练,这也是未来大语言模型需要解决的问题。

Q9:有声音认为,国内模型开发公司的研究进度要比海外公司落后2年左右,这个观点您认同吗?差距主要在哪?

A9:我个人觉得大家都比Open AI要落后2年,不只是国内,国外其他公司也一样。

因为Open AI选择的这条路线,在ChatGPT发布之前,大家都觉得它只是一条路线而已,都不觉得它会是一条通往未来通用人工智能的标准路线。

ChatGPT出现之后,现在注册用户已经超过1亿了,这是以前从来没有过的一个数字。这个现象让大家觉得,朝这个方向做通用人工智能是完全有可能的,而且ChatGPT也展示了潜力。

Q10:现在入局的互联网科技公司,您认为哪些或者有哪些积累的企业具备做出高质量ChatGPT的实力?

A10:现在做自然语言处理的初创公司有很多。

像智源研究院、百度这样的互联网科技公司,阿里巴巴、京东这样的传统互联网公司,都具备做出类ChatGPT产品的能力。

还有知乎,大家觉得它会成为未来类ChatGPT产品的基础语料库,这会给知乎带来很多流量。

Q11:我们已知ChatGPT会对搜索引擎产生较大的颠覆作用,除此之外,还会颠覆哪些赛道?

A11:下一步应该就是图像和视频。据我所知,现在也有很多关于图像和视频的大模型,只不过它们并没有像自然语言走得那么靠前。

基于ChatGPT 这个大模型本身会有很多衍生产品,未来它可能会成为一个基石,跟各行各业的需求结合起来。

Q12:ChatGPT的算力对芯片提出了巨大的挑战,目前我国的芯片技术能否达到ChatGPT的算力需求?

A12:目前国内的芯片技术肯定是比国外要弱一些。虽然会比国外弱一点,但它不是决定因素。

我们说,如果智商不够,也可以靠数量来凑。ChatGPT的算力需求,国内的芯片还是可以达到的。

其实高端芯片的困境,不太会影响类ChatGPT在我国的开发,能做大模型创新的公司其实很少,也就是几个主流的互联网公司,像百度、华为都有自己的芯片体系,这对他们来说应该不是大问题。

但是芯片也等于是算力的价格,假如芯片便宜,那么在后续运行大模型时,它的成本就会比较低,现在可能看不太出来,以后就会成为一个重要的竞争力,因为未来每个公司都在做类ChatGPT产品,那么成本就是一个重要的考量标准。

Q13:该如何认知类ChatGPT产品之于我国互联网产业的战略意义?

A13:从自主可控的角度来讲,国家会需要有属于自己的大模型。

我国现在已经有了大模型,虽然跟国外有差距,但是差距并不是特别大。

研发类ChatGPT的产品,这是一个值得去战略思考的,需要去做战略储备、战略决策或者战略指引的一个事情。

Q14:作为一个普通人,我为什么要关注ChatGPT?ChatGPT未来会取代我的工作吗?

A14:AI替代的不是人类,而是不会使用AI的人类。

我们要关注ChatGPT的原因,在于需要了解以后应该怎么使用ChatGPT相关的AI产品去提升自己的工作效率,这是我们以后工作中的最优选择。

产业革命、工业革命之所以是革命,就是因为它对我们每个人的生活都产生了影响,比如以前的蒸汽机、电力、互联网,现在没有人不使用它们。

AI技术被我们认为是一个新的工业革命,原因也是一样。

所有人的生活,都会因为AI产品本身或者是AI衍生的其他产品而产生改变。当所有人都在进步,只有我们一成不变,形成数字鸿沟,那么受到影响的就会是我们自己。

但同时,AI并不一定能替代人类工作,现在我们也可以看到,它的精确度并不是很高,它还存在很多问题,如事实性、时效性和理解程度。

所以应该做的不是焦虑、恐慌,而是跟上发展的浪潮,主动了解ChatGPT,以便更好地使用。

Q15:用ChatGPT搞副业行得通吗,比如帮写网文?

A15:不能说完全不行,但要用它写出充满可读性的网文,需要比较精心的引导,目前还达不到给它一份大纲,它就能生成非常完美的一篇网文的程度。

现在的情况更多的是,我们给它大纲,然后它生成一篇充满套路的文章。

也就是说:华丽的词藻,但是空洞的思想。

未来互联网上的信息会更加膨胀,大家会更偏向看有质量的东西,那么ChatGPT生成的充满套路的文章肯定是行不通的。

Q16:人类应该以怎样的正确态度来面对ChatGPT?

A16:AI首先是一个工具。从这个角度上来看,我们应该考虑到,工具和技术本身没有善恶,但它的使用角度可能会有问题。

而且,人工智能这样一个工具,严重地依赖它的数据,还有它的生成过程。所以我们希望人类本着负责任的态度去使用它,这样大模型生成的内容也是相对负责任的。

另外一方面,就是我们日常担忧的AI问题。

最近也有一些人在谈论,ChatGPT这类大语言模型,除了现在的仿造能力,将来会不会涌现其他新的能力,比如逻辑思维能力,这是今年热度很高的一个问题。

这也是我们目前正在研究的问题,如果有一天它真的出现逻辑思维的能力,或者开始出现类似于小孩的心智,那么可能会变成一个比较严重的问题。

但迄今为止,我们还没有发现AI有超越人类智能或者企图反叛人类的苗头。

Q17:新技术的风险一般伴随着法律和伦理上的讨论。ChatGPT的风险主要体现在哪些方面?

A17:这应该是对大模型的普遍担忧。

第一个就是,数据公平的问题。有很多模型的训练集本身就没有公平,导致它产生的结果就是不公平的。

第二个是,它的答案可能是有害的。目前ChatGPT已经对很多领域都已经做出了限制,我们很少能看到有害的问题和有害的答案。但是如果有新的模型,它们可能没有做出限制,就很难避免。

第三个是,现在AI界在强调的,我们要做负责任的AI。AI只是一种技术,但作为技术的生产商,需要让这个技术对人类负责任,它的每一个决定都不能随意。

评论