文|科技新知 王思原

编辑|伊页

自然语言处理(NLP)技术的发展和运用,使得计算机性能增长速度一举跃过摩尔定律瓶颈,将AI拱入属于它的高光时代。而象征技术融合的ChatGPT一夜爆红,仿佛给整个商业社会带来了一次“技术革命”。

微软、谷歌、百度、华为、阿里...全球范围内的科技巨头,争先恐后真金白银地押注,掀起了一场以资本和技术为基础的生态竞速。

无疑,GPT模型在这场革命中扮演了一个举足轻重的角色。从GPT-3到GPT-3.5,再到现在的GPT-4,我们已经见证了这个模型能力的惊人飞跃。

然而,这是否意味着我们已经看到了GPT的终局?接下来,本文将从垂直、个人、离线三个维度,对GPT的发展趋势、未来前景进行一些基于客观现实的大胆猜想。

垂直GPT百花齐放

3月的最后一天,彭博新闻社发布了专门为金融领域打造的大型语言模型(LLM)——BloombergGPT,引发金融圈“地震”。

基于LLM的生成式人工智能,已经在许多领域展示了令人兴奋的新应用场景。但是,金融领域的复杂性和独特的术语,意味着其需要特定的语言模型。作为全球最大的财经资讯公司,彭博社在这方面恰好拥有巨大优势。

在过去40年里,彭博收集了海量的金融市场数据,拥有广泛的金融数据档案,涵盖一系列的主题。使用该公司数据终端的客户遍布全球,包括交易员、投行、美联储、美国其他官方机构以及全球各大央行等。

这些特有数据,使得BloombergGPT比ChatGPT拥有更专业的训练语料。据彭博社发布的报告中可以看出,研究人员利用彭博社现有的数据,对资源进行创建、收集和整理,构建了一个3630亿个标签的数据集,并基于通用和金融业务的场景进行混合模型训练,以支持金融行业内各种各样的自然语言处理(NLP)任务。

除了金融领域,医疗、教育也均有更为垂直的GPT产品涌现。例如,IBM Watson Education推出了一款名为“Teacher Advisor with Watson”的教育GPT,可以为教师提供个性化的教学建议和支持;Kheiron Medical推出的“MIA”医疗GPT,可以为医生提供乳腺癌筛查和诊断支持。

相对于“广而泛”的ChatGPT,垂直GPT的发展优势十分明显。

首先就是成本上,垂直GPT针对特定领域或行业进行优化,只需利用该领域内的专业数据进行训练,避免了ChatGPT那样数据采集的高成本和高难度。

另外对比通用的GPT产品,垂直GPT的训练成本和应用成本更低。由于垂直GPT针对特定领域进行优化,训练数据更加专业化和精细化,可以通过更少的数据和更短的训练时间,获得更好的效果。

而垂直GPT在特定领域的应用效果更好,能够更准确地理解和处理领域内的语言数据,从而减少了后续的人工修正和调整成本。

更低的训练成本、更短的训练时间、更精细的训练内容,能够为企业提供更高效、准确、具有定制性的自然语言处理服务,优化企业的业务流程和数据分析能力,从而为企业带来更多的商业价值和竞争优势,这也使得垂直GPT在商业化上更加出色,资本市场和相关企业也更加看好这一方向。

值得一提的是,更垂直的GPT也意味着企业需要有更专业、更精准、更安全的数据语料,未来企业的竞争点也将围绕专业数据、清洗和标注数据的能力、用户隐私安全三点展开。

不可否认,随着各行各业对自然语言处理技术的需求不断增长,GPT模型被应用到更多的垂直领域中已被提上日程,未来将会看到更多专业的垂直GPT产品出现。

个人GPT并不遥远

因为与通用GPT的模型存在一定不同,垂直GPT的独特性、定制性在未来也可能促进个人GPT的出现。

个人GPT是指为个人用户提供个性化的自然语言处理服务的GPT模型。个人GPT可以学习用户的语言习惯、兴趣爱好、生活方式等信息,从而为用户提供更加个性化、贴近用户需求的自然语言处理服务。

这看起来非常不可思议,但并非无法实现。

从底层实现逻辑技术来看,GPT的核心是基于Transformer架构,结合预训练模式、多层结构、无监督学习和Fine-tuning微调等特点,通过对输入语料的学习得到进化。也就是说,如果能够在个人PC上实现这些步骤,那么就有构建GPT的可能。

目前市面上已经出现了大量开源大模型、公开语料包,基于这些模型可以快速进行语料训练,而其中的难点无非在于处理数据的能力、以及对训练好的模型进行评估和优化。简单来讲,如果PC上安装了足够优秀的GPU、CPU等核心处理器,完全能够实现个人GPT的训练。

当然,训练个人GPT模型所需的硬件配置取决于许多因素,例如模型的规模、数据集的大小、训练算法和优化器的选择等。

以下是ChatGPT给到的一些通用建议和参考:

CPU:训练大型的GPT模型需要强大的CPU计算能力,建议使用多核心的CPU处理器,例如Intel Xeon、AMD EPYC等型号的服务器级别CPU。

GPU:GPU是训练大型GPT模型必不可少的重要组件,建议使用高性能、内存大的GPU,例如NVIDIA Tesla V100、A100等型号,以提高模型训练速度和效率。

内存:训练大型GPT模型需要极高的内存消耗,建议使用大容量的内存,例如64GB以上的服务器内存。

存储:训练大型GPT模型需要大量的存储空间,建议使用高速、大容量的SSD或NVMe硬盘,以提高数据读写速度和效率。

网络:训练大型GPT模型需要大量的数据传输和通信,建议使用高速、稳定的网络连接,例如千兆以上的以太网或InfiniBand网络。

需要注意的是,训练个人GPT模型需要极高的计算资源和时间成本,建议使用云计算服务或租用高性能计算资源进行训练,以提高效率和降低成本。同时,还需要选择合适的训练算法、优化器和超参数等,以提高训练效果和准确性。

值得一提的是,前不久王健林独子王思聪再次对家中的“百万服务器”进行新一轮网络改造,有业内人士推测主要目的就是提高服务器算力,以训练个人GPT。

不过如果想要建立高质量的GPT模型,需要大量的高质量训练数据语料,但是除了公开语料包外,个人用户很难获得大规模的高质量训练数据,因此需要花费大量的时间和精力采集和处理数据,这也是个人在搭建GPT时的难点。

还需要注意的是,在个人PC上创建独立的GPT需要大量的计算资源和时间,并且需要具备一定的机器学习和自然语言处理技术知识。除此之外,还需要关注大模型的可扩展性,以及数据隐私和安全问题,确保训练数据和模型的高效性和保密性。

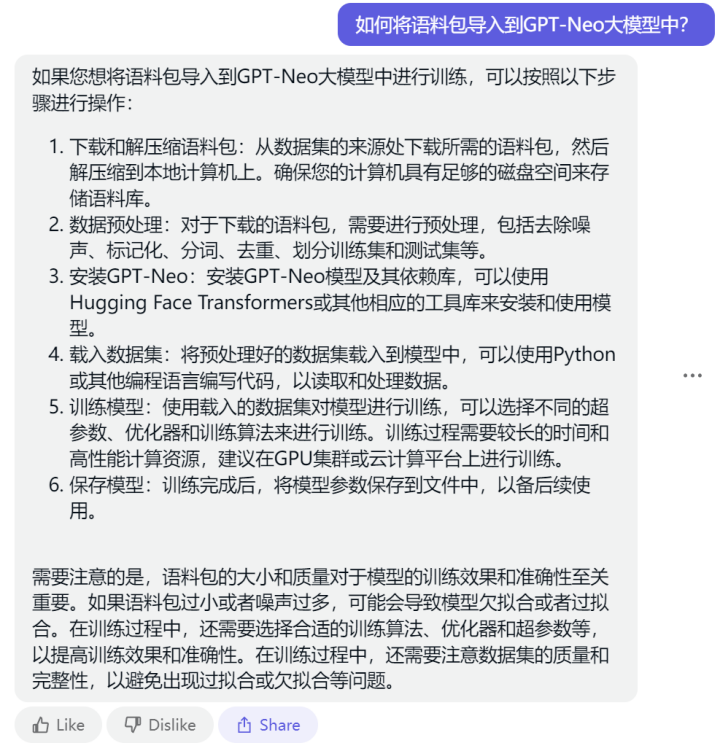

当然,对于普通用户来说,构建训练环境、调用开源大模型、寻找训练语料等等几乎每一步都是一个门槛。但在「科技新知」尝试后发现,除了不能帮助直接购买所需的硬件外,ChatGPT可以协助解决搭建过程中几乎80%的问题。

近期,OpenAI暂停ChatGPT Plus付费服务的消息传得火热,加上前几天部分地区普通账号大面积封号,虽然问题暂时得到解决或缓解,但ChatGPT计算资源供不应求的问题还是浮现出水面。

业内人士统一认为这是因为算力不足导致GPT-4的响应速度变慢,错误答案增加,微软作为ChatGPT的金主,曾大力投入资源提升其算力并承诺继续提升,但现在似乎还不太够。

这也更加突出个人GPT的必要性。另外从底层逻辑来看,个人GPT除了个性化定制、隐私安全性更高、使用更高效外,还有一个更值得关注的优势,就是离线使用。而在「科技新知」看来,离线GPT也是未来发展的一个主要方向。

离线GPT不无可能

GPT模型的训练和推理,需要大量的计算资源和存储空间,这使得云端环境成为了主流选择。但是,在一些特定场景下,如边缘计算、无网络环境等,离线GPT模型的需求也并不少。

更为实际的,比如采矿等特殊环境行业,离线GPT可以结合监控系统和数据分析技术,分析矿山环境、工人健康状况等信息,从而实现安全管理和风险预警,减少矿难和事故的发生,保障矿工的生命和财产安全。

通用GPT显然无法实现在有限的存储空间内,给到无限可能的答案。因此,「科技新知」认为“离线+专业”是GPT未来极可能实现的发展方向。

微软刚刚发布了一款代号“贾维斯”的人工智能虚拟助手,它是一个集成了大型语言模型(LLM)和专家模型的框架,用于处理任何模式或领域中的复杂任务。

简单来讲,贾维斯类似AI与AI之间的协作系统,可以通过大型语言模型组织模型之间的合作,来处理任何模式或领域的任务。通过大型语言模型的规划,可以有效地指定任务过程并解决更复杂的问题。

不妨设想一下,将矿业行业的GPT模型与贾维斯结合,再通过机器狗作为运行载体,由贾维斯作为中台,向机器狗传递GPT模型所提供的信息,可以实现一定程度上的自主作业。

具体而言,机器狗可以通过搭载各种传感器、控制器和执行器等设备,收集、处理和执行矿业作业所需要的各种数据和指令。

贾维斯作为中台,可以实时监控机器狗的运行状态、矿产资源的勘探和开采情况等信息,通过离线GPT模型分析和预测矿产资源的位置、规模和开采效率等指标,向机器狗传递智能化的勘探和开采指令,实现对机器狗的自主控制和作业。

客观来讲,这样的模式也可以复刻到高空机器人、医疗机器人等特殊领域中。

不过在这个过程中,也需要解决客观存在的技术难题。而其中最为关键的就是训练中的语料数据存储。

除了训练好的垂直GPT需要占用大量内存外,贾维斯系统也需要处理大量的语音和文本数据,包括语音识别、自然语言处理、知识图谱等任务,以实现语音输入、文本输出、任务执行等功能。如果全部在本地进行训练,则需要大量的计算资源和存储空间,以保证贾维斯系统的准确性和效率。

值得一提的是,贾维斯系统非常强大,但官方给出的电脑最低配置要求是:

NVIDIA GeForce RTX 3090 显卡一张

16GB 内存 最低配置

42GB以上内存 理想配置

也就是说,如果能够解决训练语料的存储问题,或者训练方法有简化突破后,离线GPT甚至离线“贾维斯”也不无可能。

最后,AI的快速发展已经让各行各业感受到了“工具在进步”,甚至一部分人已经喊出“The future has arrived”,但这仍只是个开始,更多的技术创新和应用场景将会不断涌现,好戏还会逐渐上演。

(本文系作者与ChatGPT联合撰写)

评论