文|侃科技

今年3月,面对汹涌而来的AI潮,“硅谷刀王”一改往日本色,主动站到台前,宣布推出DGX云,把AI专用的GPU放到云上「出租」。

以往,出售算力这种事都是云计算公司在干。它们购买多种型号显卡与人工智能加速器,根据硬件性能或使用时长等方式定价,然后租给下游客户。

这个过程中,英伟达将GPU要么卖给云计算平台,要么直接出售给AI公司,比如第一台NVIDIA DGX超级计算机就是2016年老黄亲自交付给OpenAI的,并没有直接出售算力,顶多算「卖铲人」。

而DGX上云这个事,虽然英伟达仍需要将其托管到云平台,但本质上已经是跨越边界了。

一向屈居幕后的英伟达,这次为何要走向台前?

本轮AI潮英伟达毫无疑问是最大的受益者,甚至可以没有之一。

用于训练AI的GPU芯片价格疯长,海外A100和H100的每片价格分别涨到了1.5万美元和4万美元,国内一台配置8颗A100和80G存储空间的AI服务器,价格也从去年中旬的8万/台飙升至当前的165万/台。

但这些钱并没有都流入英伟达的口袋,溢价都被渠道拿走了,关键是这种倒买倒卖英伟达还一点办法没有。

DGX云就在这种情况下应运而生,关键价格看似还很便宜。配备8个H100 GPU模组的DGX云,每月套餐费只要3.7万美元,相当于单片H100的价格。

对于急需算力资金又捉襟见肘的AI公司来说,DGX云无疑是渴睡时天降的一个枕头;对英伟达而言,出售云算力既能赚钱又绑定了客户。

而看似双赢的背后,却隐藏着一场始于AI的秘密战争。

算力平权

从产业特点看,今天基于云算力的AIGC和曾经的加密资产挖矿极其相似,但需要的资源远高于后者。

国盛证券曾在《Web3 视角下的AIGC算力进化论》中,比较了加密资产挖矿和AIGC产业的异同点:

1、AIGC产业耗电量大约会在1.6-7.5年间超过当前比特币挖矿产业耗电量,主要驱动因素是GPT类大语言模型在模型参数、日活和模型数量上的高速增长;

2、和比特币挖矿类似,AIGC产业由算力驱动的内容处于高强度竞争中,参与者只有持续、快速生产出高质量内容,才能保证自己获取到的用户注意力不会下降。

这就导致AIGC产业的两大特点:高成本和持续性。

其中,成本侧不止是耗电量,当然耗电量可以作为一个非常直观的证据。比如百度用于训练推理文心一言的阳泉超算中心,每小时耗电64000kW·h(度),按照0.45元/kW·h的商业用电标准,一年电费就达到2.5亿。

而更大的成本则是来自算力投入。

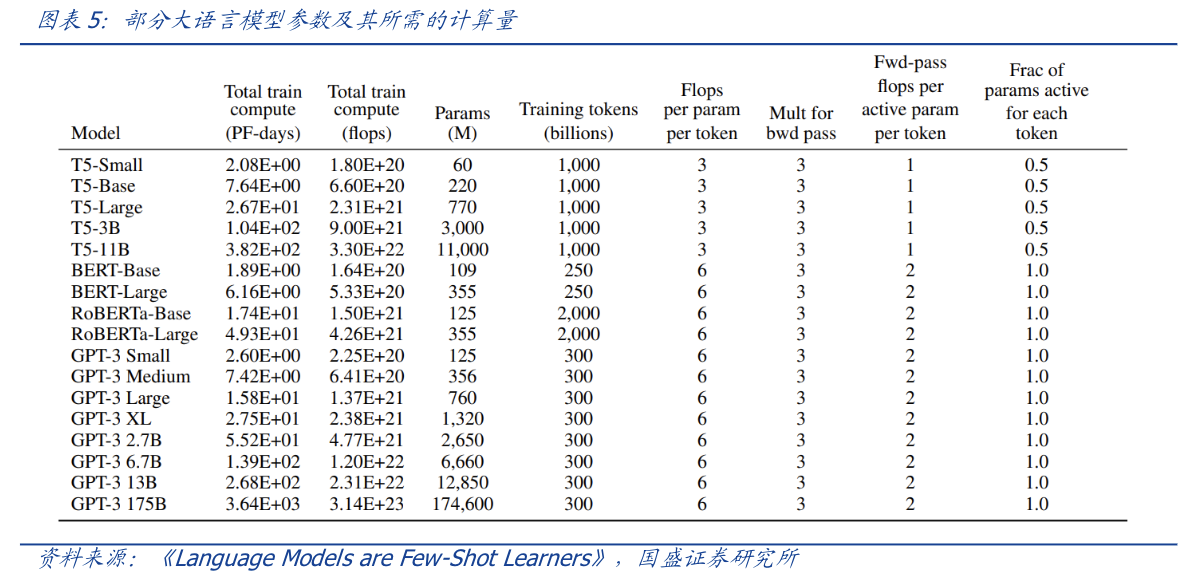

以ChatGPT为例,不考虑与日活高度相关推理过程所需的算力,仅考虑训练过程,根据测算,1750亿参数的GPT-3训练一次大约需要6000张英伟达A100显卡,如果考虑互联损失,大约需要上万张A100。

按单张A100芯片10万计算,大规模训练就需要投入约10亿,一般厂商根本承担不起。而GPT-4的模型参数更大,训练的标识符更多,所需算力更为可观。

并且,随着更多AIGC大模型的发布,其所需算力直线狂飙。

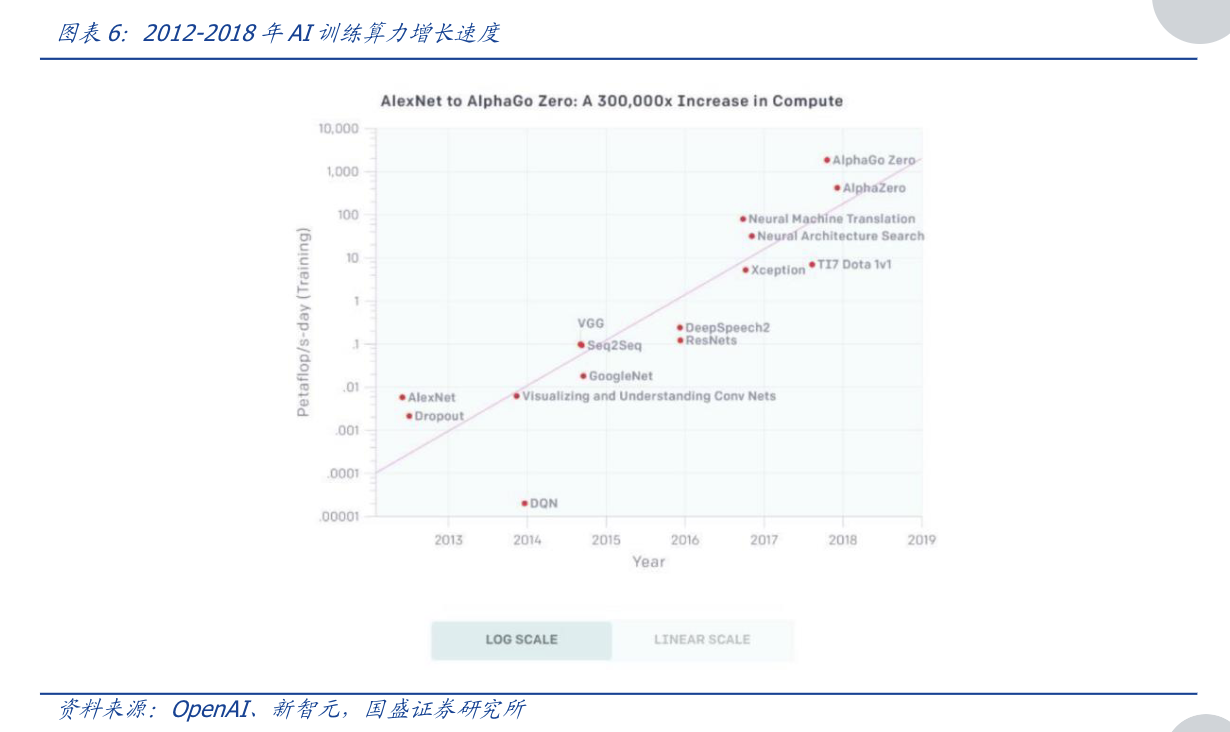

根据OpenAI测算,自2012年至2018年,用于训练AI所需要的算力大约每隔3-4个月翻倍,总共增长了30万倍(而摩尔定律在相同时间只有7倍的增长), 每年头部训练模型所需算力增长幅度高达10倍,整体呈现指数级上涨。

这个时候就体现出云算力的优势了,总结下来可以归结为8个字:化整为零,按需付费。

云算力能让AIGC大模型厂商无需购买英伟达A100显卡等硬件,而直接按需租用云算力平台提供的算力,这使得初创企业或非头部模型厂商也能尝试进入AIGC领域。

甚至这种“化整为零”的方式,对产业链各方都有益处:

1)对上游算力生产商而言,在算力硬件进入淡季、库存趋增时,能通过售卖云算力的方式,平滑收入的波动,并为旺季储备“有生”力量,及时满足回弹的市场需求;

2)对中游云服务厂商而言,则有助于增加客流;

3) 对下游算力需求方而言,能最大化降低使用算力的门槛,驱动全民AIGC 时代降临。

如果AIGC大模型厂商愿意让渡更多资源,还可以更深入地与云平台合作。这方面的典型案例是微软云与OpenAI的合作,两者的合作没有停留在算力租用上,而深入到了股权与产品的融合。

另外,在大模型竞赛中,除了显性的硬件投入成本,还有一个隐形的时间成本。

一般而言,大模型对于算力的需求分为两个阶段,一是训练出类ChatGPT大模型的过程;二是将这个模型商业化的推理过程。

而且这个过程越持续大模型就越好。所以现在再来看英伟达DGX云,就不难搞懂老黄干了一件什么事。

用云的方式把用于AI训练的GPU价格打下来,算力平权笼络中小公司,再基于大模型训练的持续性因素绑定客户,“硅谷刀王”一举两得。

受益的未必是英伟达

从去年12月开始,英伟达A100的价格5个月累计涨幅达到37.5%,同期A800价格累计涨幅也达到了20.0%。

GPU价格暴涨无疑增加了AIGC训练大模型的门槛,但对于头部厂商而言,涨多少价GPU都是要买的。但对于腰部公司来说,不涨价可能咬咬牙还能下单,一涨价就只能望GPU兴叹了,王慧文创业拿到的5000万美金融资,可能连训练所需的显卡都买不全。

所以,老黄在这个时候拿出DGX云,就像开了一家豪车租赁公司,让买不起的人也能租用。

当然,这背后英伟达的另一层考量,即抢在竞争对手前面,绑定更多的中小客户。

本轮AI热潮中除OpenAI外,最出圈的AI公司非Midjourney和Authropic莫属了。前者是一款AI绘图应用,最近同QQ频道合作开启了国内业务,后者的创始人则是出自OpenAI,其对话机器人Claude直接对标ChatGPT。

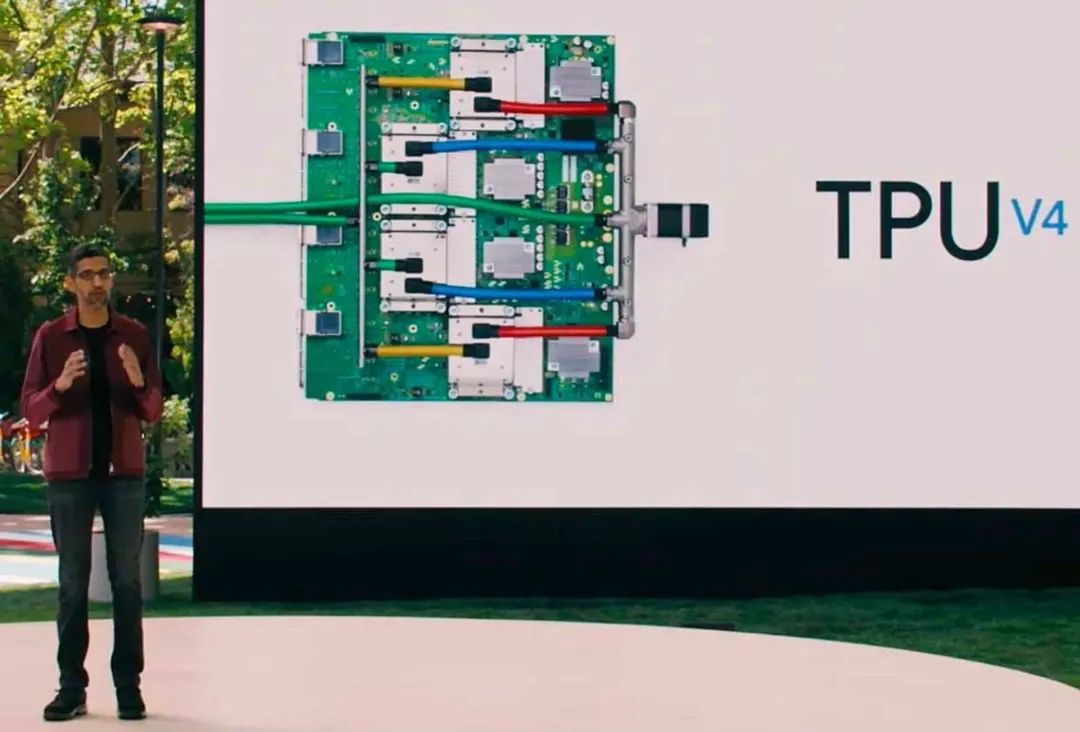

这两家公司有一个相同点,就是都没有购买英伟达GPU搭建超算,而是使用Google的算力服务。

该服务由一个集成4096块TPU v4的超算系统提供,重点是Google自研。

另外一家搞自研芯片的巨头是本轮AI浪潮的引领者微软,传闻这款名叫Athena的芯片采用5nm先进制程,由台积电代工,研发团队人数已经接近300人。

很明显,这款芯片目标就是替代昂贵的A100/H100,给OpenAI提供算力引擎,并最终一定会通过微软的Azure云服务来抢夺英伟达的蛋糕。

除了云计算公司的背刺,英伟达的大客户特斯拉也要自己单干。

2021年8月,马斯克就向外界展示了用3000块自家D1芯片搭建的超算Dojo ExaPOD。其中D1芯片由台积电代工,采用7nm工艺,3000块D1芯片直接让Dojo成为全球第五大算力规模的计算机。

相较之下,国产芯片可以做对信息颗粒度要求没有那么高的云端推理工作,但大多目前无法处理超高算力需求的云端训练。

燧原科技、壁仞科技、天数智芯、寒武纪等公司都推出了自己的云端产品,且理论性能指标不弱。

据此前曝光的信息,百度用于训练推理文心一言的阳泉超算中心,除了A100还用了一些国产化的产品,比如百度自研的昆仑芯和寒武纪的思元590,其中有消息显示2023年采购计划思元大概占10%-20%。

其中,文心一言的芯片层核心能力来自昆仑芯2代AI芯片,其采用自研XPU-R架构、7nm工艺和GDDR6高速显存,通用性和性能显著提升;具有256 TOPS@INT8和128 TFLOPS@FP16的算力水平,较一代提升2-3倍。

今年3月,李彦宏也在亚布力中国企业家论坛上分享,昆仑芯片现在很适合做大模型的推理,将来会适合做训练。

尾声

从RIVA128开始,英伟达就展示了自己惊人的市场观察能力。过去的十几年里,从加密货币挖矿到元宇宙,再到AI潮,英伟达顺势将显卡的客户从游戏玩家拓展到了科技巨头。

伴随着战火蔓延,英伟达市值也一路高歌,从一个二线芯片公司变成了全行业的No.1。只是,黄仁勋说AI的iPhone时刻已到来,那么诺基亚都被苹果打败,英伟达又怎能是无敌的呢。

参考资料

[1] AIGC的看多期权:AI云算力,国盛证券

[2] Web3 视角下的AIGC 算力进化论,国盛证券

[3] 英伟达帝国的一道裂缝,远川研究所

[4] 云算力挖矿可能是现在入场比特币最稳的路,Odaily星球日报

[5] 百度“文心一言”专家解读,独角兽智库

[6] 大模型时代,国产GPU加速「狂飙」,数字时氪

[7] 英伟达黄仁勋:将通过中国云服务商提供AI超算能力,AI的iPhone时刻到来! 第一财经

[8] AI算力产业链梳理:技术迭代推动瓶颈突破,AIgc场景增多驱动算力需求提升,安信证券

评论